Орда экскаваторов начинает свою ежегодную миграцию в поисках нового источника пищи

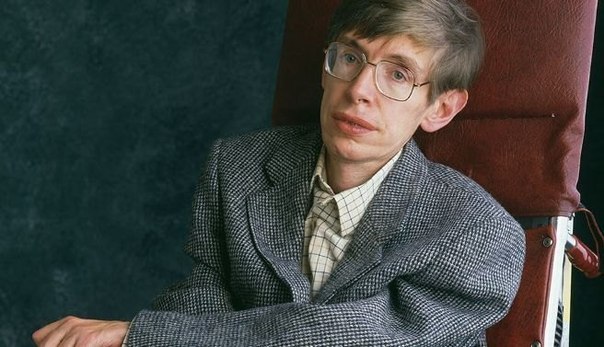

Стивен Хокинг: человечество обречено, если не покинет Землю Если человечество хочет выжить в долгосрочной перспективе, ему нужно найти способ покинуть планету Земля. Знакомые слова? В этот раз они прозвучали из уст известного астрофизика Стивена Хокинга. Возможно, у людей осталось меньше 200 лет, чтобы выяснить, как сбежать с родной планеты, заявил Хокинг в недавнем интервью Big Think. В противном случае нашему виду может грозить вымирание. «Будет довольно сложно избежать катастрофы в ближайшие сто лет, не говоря уже о следующей тысяче или миллионе лет, — сказал Хокинг. — Наш единственный шанс долговременного выживания — не остаться на планете Земля, а распространиться в космосе». Людей, застрявших на Земле, ждет риск двух типов катастроф, считает Хокинг. Первый тип мы можем создать самостоятельно, к примеру, вызывая кардинальное изменение климата или создав ядерное или биологическое оружие. Может стереть нас с лица Земли и ряд космических явлений. Астероид, столкнувшийся с Землей, убьет большую часть населения и оставит остальную часть планеты непригодной для жизни. Вспышка гамма-лучей сверхновой недалеко в Млечном Пути тоже может оказаться разрушительной для жизни на Земле. Жизнь на Земле также может быть под угрозой внеземных цивилизаций, о чем любит говорить Хокинг. Опасные чужаки могут завладеть планетой и ее ресурсами для собственного использования. Для выживания нашего вида было бы безопаснее иметь запасной план в виде других миров. «Человеческой расе не стоит держать все яйца в одной корзине, или на одной планете. Будем надеяться, что мы не уроним корзину, пока не перераспределим нагрузку». На днях Хокинга спросили, какие недостатки людей он бы изменил, а какие добродетели улучшил, если было бы возможно. Он ответил: «Больше всего я бы хотел поправить в человеке его агрессию. Она давала преимущество при выживании в дни пещерных людей, чтобы получить больше еды, территории или партнера, с которым можно продолжить род, но сегодня она угрожает уничтожить нас всех». В ноябре Элон Маск, генеральный директор SpaceX и Tesla, предупреждал, что шанс на то, что случится нечто опасное в результате появления машин с искусственным интеллектом, может выстрелить уже через пять лет. Ранее он утверждал, что развитие автономных думающих машин сродни «призыву демона». Выступая на симпозиуме AeroAstro Centennial в октябре, Маск описал искусственный интеллект как нашу «крупнейшую угрозу для выживания». Тогда он сказал: «Я думаю, нам стоит быть очень осторожными с искусственным интеллектом. Если бы я мог предположить, какой будет наша крупнейшая угроза для выживания, то это он. Нам нужно быть очень осторожными с искусственным интеллектом. Я все больше и больше склоняюсь к тому, что должен быть некий регулятивный надзор, возможно, на национальном и международном уровне, просто чтобы знать, что мы не делаем дурацких ошибок». «С искусственным интеллектом мы вызываем демона. Вы знаете эти истории, в которых парень с пентаграммой и святой водой… он думал, что сможет контролировать демона, но нет». Возвращаемся к Хокингу. «Качество, которое я хотел бы улучшить — это эмпатия, сочувствие. Она удерживает нас в состоянии мира и любви». Профессор также добавил, что космическая гонка для людей будет «страхованием жизни» и должна продолжаться. «Отправка людей на Луну изменила будущее человеческой расы таким образом, о котором мы пока даже не подозреваем, — сказал он. — Она не решила наши насущные проблемы на планете Земля, но позволила нам взглянуть на них под другим углом, изнутри и снаружи». «Я считаю, что долгосрочным будущим человеческой расы должен быть космос и что он представляет собой важную страховку жизни для нашего дальнейшего выживания, поскольку может препятствовать исчезновению человечества путем колонизации других планет». В декабре 2014 года Хокинг выступил с другим предупреждением — что искусственный интеллект может означать конец человеческой расы. Выступая на мероприятии в Лондоне, физик рассказал BBC, что «развитие полноценного искусственного интеллекта может положить конец человеческой расе». В январе группа ученых и предпринимателей, включая Элона Маска и Стивена Хокинга, подписала открытое письмо, обещающее положить начало исследованиям безопасности ИИ. Письмо предупреждает о том, что без каких-либо гарантий развитие умных машин может означать темное будущее для человечества.

читать далее

Будьте правдивы. Пишите и хорошее, и плохое, но ничего не выдумывайте.

Будьте правдивы. Пишите и хорошее, и плохое, но ничего не выдумывайте.

Пишите и хорошее, и плохое.

Пишите и хорошее, и плохое.

Ваш отзыв будет опубликован после прохождения модерации

Пишите только сами!

Автоматическая проверка находит любые копии и рерайты, автор блокируется навсегда.

Оставьте свой контактный номер телефона - мы обязательно перезвоним в удобное для Вас время!

Напишите нам подробно описав свою ситуацию. Мы обязательно свяжемся с Вами!

Определите ваше местонахождение, чтобы проверить возможность доставки